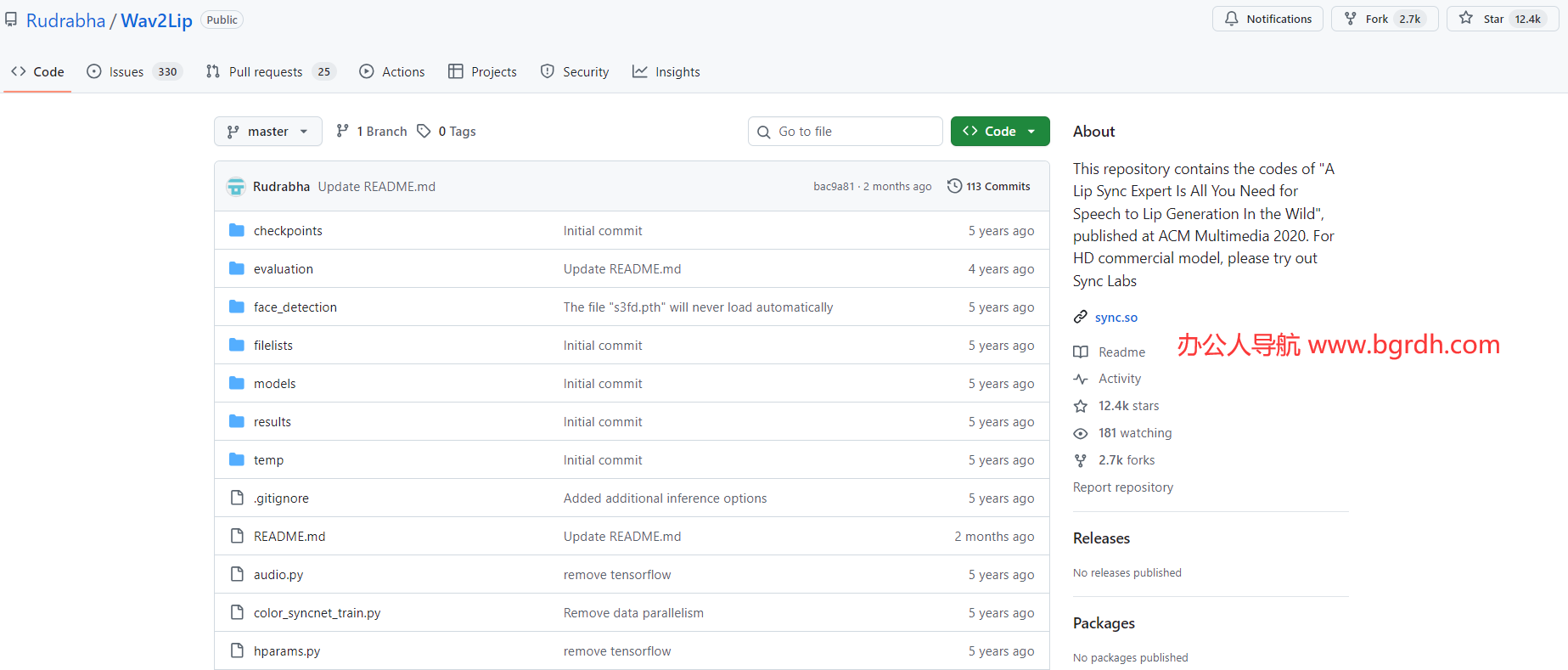

Wav2Lip 是由 Rudrabha/Wav2Lip 團隊開發的開源項目,專注于實現視頻中人物唇部動作與輸入音頻的高精度同步。該項目通過深度學習技術,能夠將任意語音或音頻與目標人物的面部視頻完美匹配,生成逼真的唇語同步效果。其核心優勢在于能夠處理多種語言、不同說話風格,并適用于各類人臉視頻,包括影視片段、動畫角色或自拍視頻。

- Wav2Lip官網入口網址:https://sync.so/

- Wav2Lip開源項目地址:https://github.com/Rudrabha/Wav2Lip

技術原理

Wav2Lip 基于生成對抗網絡(GAN)和時序卷積網絡(TCN)的結合,通過以下關鍵步驟實現唇部同步:

- 音頻特征提取:將輸入的語音信號轉換為梅爾頻譜或語音特征向量,捕捉音素和時序信息。

- 視覺-音頻對齊:使用編碼器-解碼器結構分析視頻中的人臉關鍵點,并將音頻特征與唇部運動動態關聯。

- GAN 增強真實感:通過對抗訓練生成高分辨率、自然的唇部動作,減少人工合成的違和感。

應用場景

- 影視配音與本地化:為電影、動畫或短視頻快速生成多語言配音版本。

- 虛擬主播與數字人:提升虛擬形象的唇部同步表現,增強交互真實感。

- 教育娛樂:修復老視頻的音頻問題,或為無聲視頻添加解說。

項目優勢

- 高精度同步:相比傳統方法,Wav2Lip 在唇形準確性和時序一致性上表現更優。

- 強泛化能力:支持不同人臉、語言和音頻輸入,無需針對個體進行額外訓練。

- 開源易用:提供預訓練模型和詳細教程,用戶可通過 Python 腳本快速生成結果。

局限性

- 對極端頭部姿態或遮擋場景的魯棒性有待提升。

- 超高分辨率視頻需額外后處理以保證畫質。

Wav2Lip 因其出色的效果和易用性,已成為 AI 語音驅動領域的標桿工具,GitHub 倉庫持續更新,社區活躍,適合開發者、研究者及多媒體創作者探索使用。

相關導航

暫無評論...