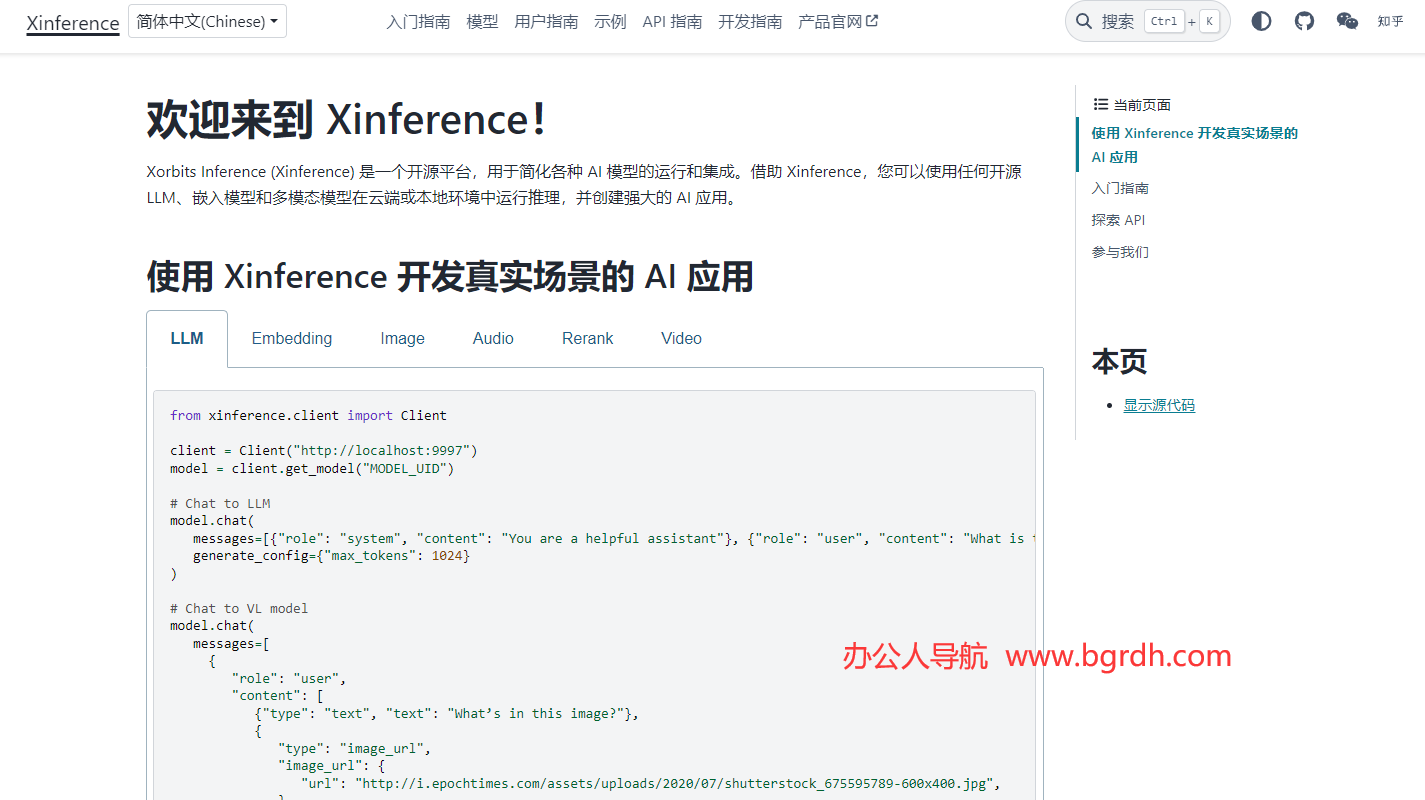

Xinference 是一個開源的 AI 模型部署與推理框架,旨在簡化大模型的部署、運行與調用流程。它支持多種模型類型,包括大語言模型(LLM)、多模態模型、語音識別模型等,并提供高性能、分布式、跨平臺的推理能力。Xinference 提供了多種部署方式,包括本地部署、容器化部署、Docker 部署等,支持多種硬件環境,如 CPU、GPU、Apple M 系列芯片等。

- Xinference官網入口網址:https://inference.readthedocs.io/

- Xinference中文官網網址:https://inference.readthedocs.io/zh-cn/

- Xinference開源項目地址:https://github.com/xorbitsai/inference

Xinference 的核心優勢包括多模型支持、靈活量化配置、跨硬件適配、分布式推理、統一 API 接口和自動模型管理。它支持多種推理引擎,如 vLLM、TensorRT、Transformers、vLLM、llama.cpp 等,能夠優化推理性能并提升模型推理效率。Xinference 還支持與 LangChain、LlamaIndex、LangChain 等框架的無縫集成,便于構建復雜的 AI 應用。

Xinference 提供了多種部署方式,包括命令行工具、RESTful API、CLI、WebUI 等,用戶可以通過命令行或 API 調用模型,支持異步調用和流式處理。Xinference 的安裝和使用相對簡便,支持通過 pip 安裝,也支持通過 Docker Compose 快速部署。

Xinference 是一個開源項目,托管在 GitHub 上,用戶可以通過 GitHub、Slack 社區、Twitter 等平臺參與項目,提交問題、報告 Bug 或提出功能請求。Xinference 的社區活躍,支持用戶交流和貢獻代碼,持續更新和優化項目。

Xinference 是一個功能強大、靈活且易于使用的 AI 模型部署與推理框架,適用于企業級和研究級的 AI 應用開發。

相關導航

暫無評論...