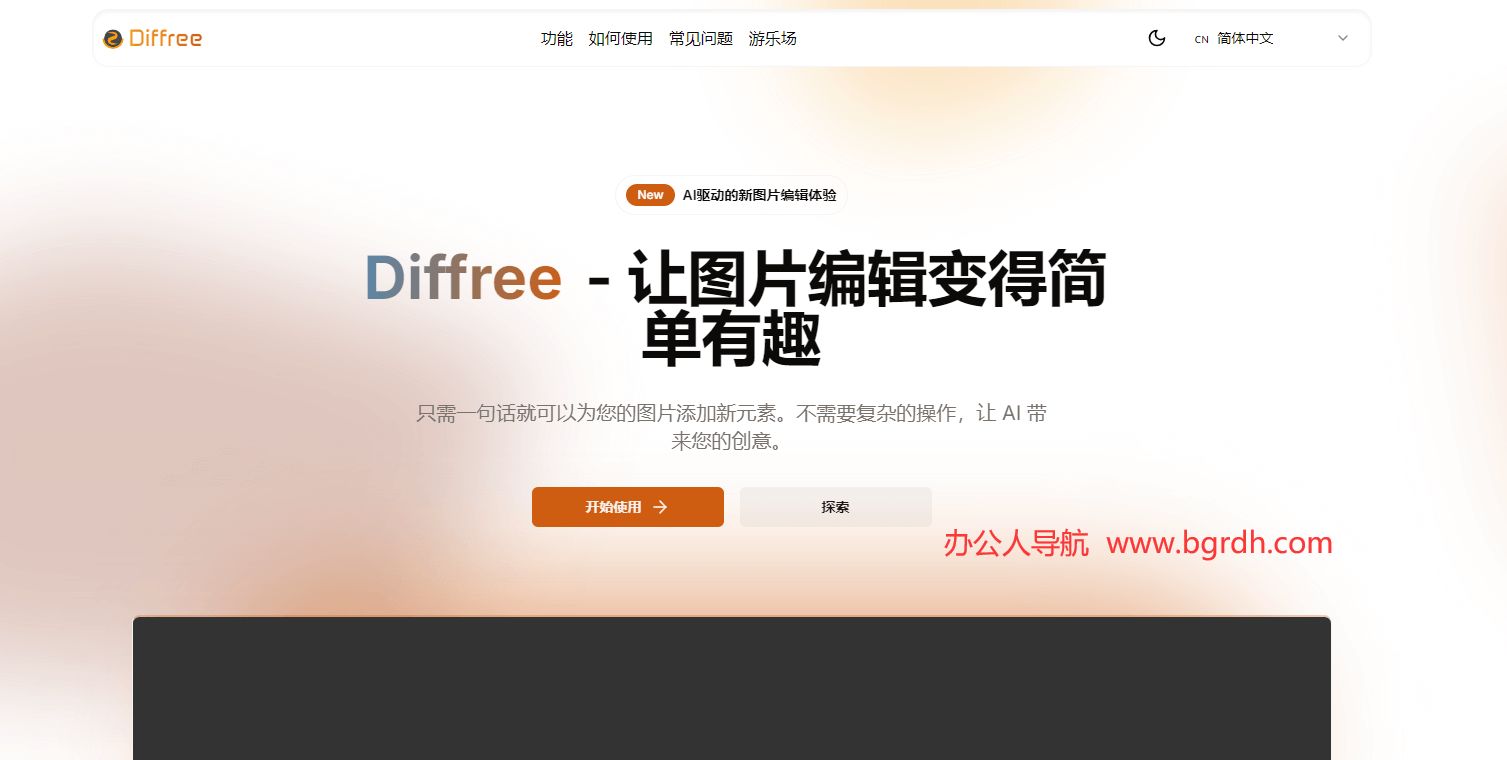

Diffree

Diffree 是一款創(chuàng)新的 AI 工具,可根據(jù)文本描述智能地向圖像中添加新對(duì)象,無(wú)需手動(dòng)繪圖或遮罩。體驗(yàn)簡(jiǎn)單高效的圖像編輯。

標(biāo)簽:創(chuàng)意設(shè)計(jì)DiffreeDiffree 是一種基于擴(kuò)散模型的文本引導(dǎo)無(wú)形狀對(duì)象修復(fù)技術(shù),旨在通過(guò)簡(jiǎn)單的文字描述在圖像中無(wú)縫添加新對(duì)象。這項(xiàng)技術(shù)由廈門大學(xué)多媒體可信感知與高效計(jì)算教育部重點(diǎn)實(shí)驗(yàn)室、上海人工智能實(shí)驗(yàn)室 OpenGVLab 和中國(guó)香港大學(xué)聯(lián)合推出,具有革命性的圖像編輯能力。

Diffree官網(wǎng)入口網(wǎng)址:https://diffree.org/zh

Diffree 的核心優(yōu)勢(shì)在于其強(qiáng)大的背景一致性、空間適應(yīng)性和高質(zhì)量輸出能力。它能夠根據(jù)用戶提供的文字描述,自動(dòng)預(yù)測(cè)新對(duì)象的位置和形狀,并確保新對(duì)象與原圖像的光線、色調(diào)和空間位置完美融合。這一過(guò)程無(wú)需用戶手動(dòng)繪制邊界框或遮罩,極大地簡(jiǎn)化了圖像編輯的操作流程。

Diffree 的技術(shù)原理基于擴(kuò)散模型和掩碼預(yù)測(cè)模塊。擴(kuò)散模型通過(guò)訓(xùn)練學(xué)習(xí)生成圖像內(nèi)容,而掩碼預(yù)測(cè)模塊則負(fù)責(zé)預(yù)測(cè)新對(duì)象的遮罩,從而實(shí)現(xiàn)無(wú)縫融合。此外,Diffree 還利用了 OABench 數(shù)據(jù)集進(jìn)行訓(xùn)練,該數(shù)據(jù)集包含 74,000 個(gè)真實(shí)世界的圖像對(duì),幫助模型更好地理解和處理復(fù)雜場(chǎng)景中的對(duì)象添加任務(wù)。

Diffree 的應(yīng)用場(chǎng)景非常廣泛,包括室內(nèi)設(shè)計(jì)、廣告創(chuàng)作、個(gè)人照片編輯等。設(shè)計(jì)師可以通過(guò)簡(jiǎn)單的文字描述快速展示創(chuàng)意效果,而無(wú)需復(fù)雜的圖像處理技能。營(yíng)銷人員可以利用 Diffree 添加引人注目的圖像元素,提升社交媒體內(nèi)容的吸引力。此外,Diffree 還為普通用戶提供了一個(gè)易于使用的工具,使他們能夠輕松實(shí)現(xiàn)高質(zhì)量的圖像編輯。

Diffree 的開(kāi)源特性進(jìn)一步增強(qiáng)了其應(yīng)用潛力。用戶可以通過(guò) GitHub 下載 Diffree 的代碼,并在本地環(huán)境中運(yùn)行,無(wú)需擔(dān)心隱私泄露或配置問(wèn)題。此外,Diffree 還提供了在線演示和 Hugging Face 模型庫(kù)鏈接,方便用戶快速體驗(yàn)其功能。

Diffree 是一項(xiàng)具有里程碑意義的圖像編輯技術(shù),它不僅降低了圖像編輯的門檻,還為創(chuàng)意表達(dá)提供了前所未有的自由度。隨著技術(shù)的不斷發(fā)展和完善,Diffree 有望在計(jì)算機(jī)視覺(jué)、創(chuàng)意設(shè)計(jì)等多個(gè)領(lǐng)域發(fā)揮重要作用。